ノーコードでクラウド上のデータとの連携を実現。

詳細はこちら →CData Software Japan - ナレッジベース

Latest Articles

- MySQL のデータをノーコードでREST API として公開する方法:CData API Server

- CData Sync AMI をAmazon Web Services(AWS)で起動

- Connect Cloud Guide: Derived Views, Saved Queries, and Custom Reports

- Connect Cloud Guide: SSO (Single Sign-On) and User-Defined Credentials

- Connect Cloud クイックスタート

- Shopify APIのバージョンアップに伴う弊社製品の対応について

Latest KB Entries

- DBAmp: Serial Number Expiration Date Shows 1999 or Expired

- CData Drivers のライセンスについて

- Spring4Shell に関する概要

- Update Required: HubSpot Connectivity

- CData Sync で差分更新を設定

- Apache Log4j2 Overview

ODBC Drivers

- [ article ] Exploratory でQuickBooks データを連携する方法

- [ article ] FoxPro でDocuSign データを操作

- [ article ] CData Software ODBC Driver を使ってAsprovaをAdobe ...

- [ article ] PyCharm でCData Software ODBC Driver を使ってSage 200 ...

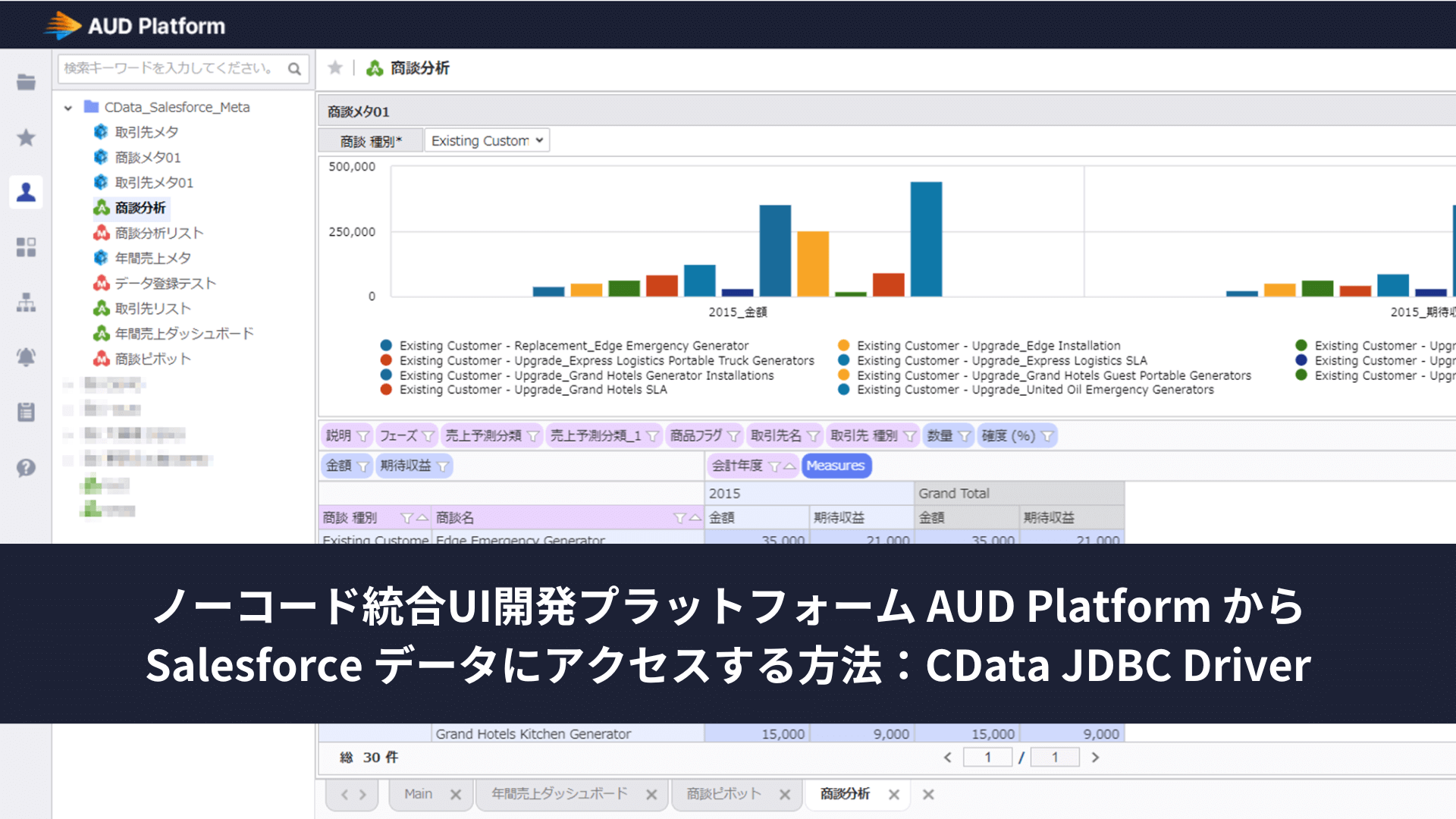

JDBC Drivers

- [ article ] Yahoo! Ads データをDataSpider Servista の連携先として使う方法

- [ article ] Google Contacts データをDataSpider Servista ...

- [ article ] JSON データをDataiku DSS にロードして分析処理を行う方法:CData JDBC ...

- [ article ] Denodo Platform でQuickBase データソースを作成

SSIS Components

- [ article ] SSIS を使ってIBM Cloud Object Storage データをSQL Server ...

- [ article ] SSIS を使ってQuickBase データをSQL Server にインポート

- [ article ] Odoo データからSQL Server に接続する4つの方法をご紹介。あなたにピッタリな方法は?

- [ article ] Microsoft Planner をSSIS 経由でSQL サーバーにバックアップする

ADO.NET Providers

- [ article ] PowerShell からMoney Forward Expense ...

- [ article ] PowerBuilder からMySQL データに接続してみた

- [ article ] ADO.NET 経由でTIBCO Spotfire でSlack データに連携してをビジュアライズ

- [ article ] 生産スケジューラFLEXSCHE へxBase からデータを取り込む

Excel Add-Ins

- [ article ] StiLL からCData Software ODBC Driver を使ってPonparemall ...

- [ article ] Microsoft Power Query からLDAP データに連携してExcel から利用

- [ article ] Microsoft Power BI Designer でCData Software ODBC ...

- [ article ] Power BI をSharePoint Excel Services ...

API Server

- [ article ] クラウドRPA Coopel でExcel データにアクセス

- [ article ] DBArtisan でOData データに連携

- [ article ] OData のデータをTableau Desktop ...

- [ article ] Web 帳票ツール PrintStream でOData データを利用した帳票を作成

Data Sync

- [ article ] PostgreSQL へのTeradata データのETL/ELT ...

- [ article ] Azure Synapse へのAzure Synapse データのETL/ELT ...

- [ article ] Power BI XMLA データからSQL Server ...

- [ article ] Google Cloud SQL へのSpark データのETL/ELT ...

Windows PowerShell

- [ article ] PowerShell からOracle Sales ...

- [ article ] Jira Service Desk データをPowerShell でMySQL ...

- [ article ] PowerShell を使ってPhoenix データをSQL Server にレプリケーション

- [ article ] PowerShell からDynamics 365 ...

FireDAC Components

- [ article ] Delphi のBullhorn CRM データへのデータバインドコントロール

- [ article ] Delphi のJSON データへのデータバインドコントロール

- [ article ] Delphi のOneNote データへのデータバインドコントロール

- [ article ] Delphi のSpark データへのデータバインドコントロール