ノーコードでクラウド上のデータとの連携を実現。

詳細はこちら →

CData

こんにちは!ドライバー周りのヘルプドキュメントを担当している古川です。

CData ODBC Driver for SparkSQL はODBC 標準のSpark からのリアルタイムデータへのアクセスを可能にし、使い慣れたSQL クエリを用いて、さまざまなBI、レポート、ETL ツールでSpark データを直接扱うことができます。この記事では、Alteryx Designer でODBC 接続を使ってSpark データに接続し、セルフサービスBI、データプレパレーション、データブレンディングから高度な分析までを実行する方法を紹介します。

CData ODBC ドライバーには最適化されたデータ処理が組み込まれており、Alteryx Designer でリアルタイムSpark データを扱う上で高いパフォーマンスを提供します。Alteryx Designer からSpark にSQL クエリを発行すると、CData ドライバーはフィルタや集計などのSpark 側でサポートしているSQL 操作をSpark に直接渡し、サポートされていない操作(主にSQL 関数とJOIN 操作)は組み込みSQL エンジンを利用してクライアント側で処理します。組み込みの動的メタデータクエリを使用すると、ネイティブのAlteryx データフィールド型を使ってSpark データを可視化および分析できます。

CData ODBC ドライバは、以下のような特徴を持った製品です。

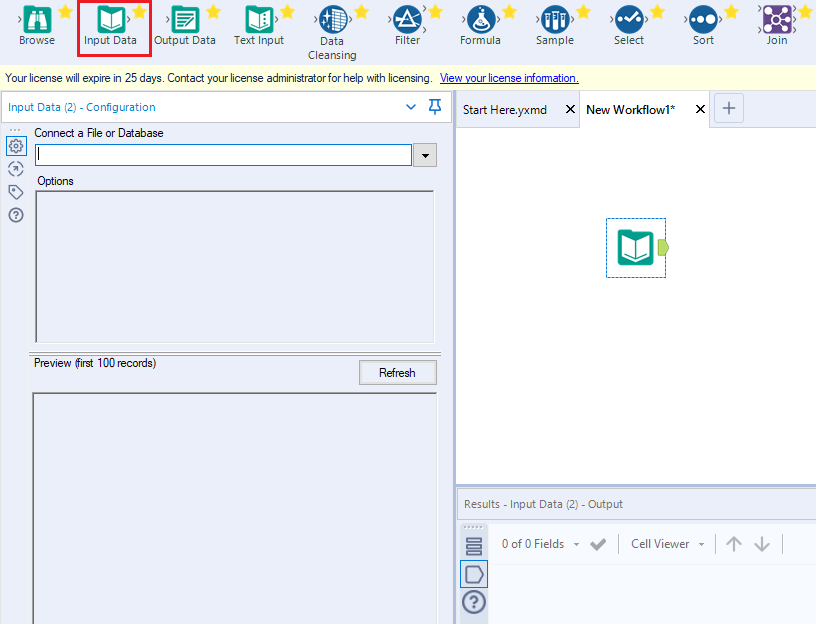

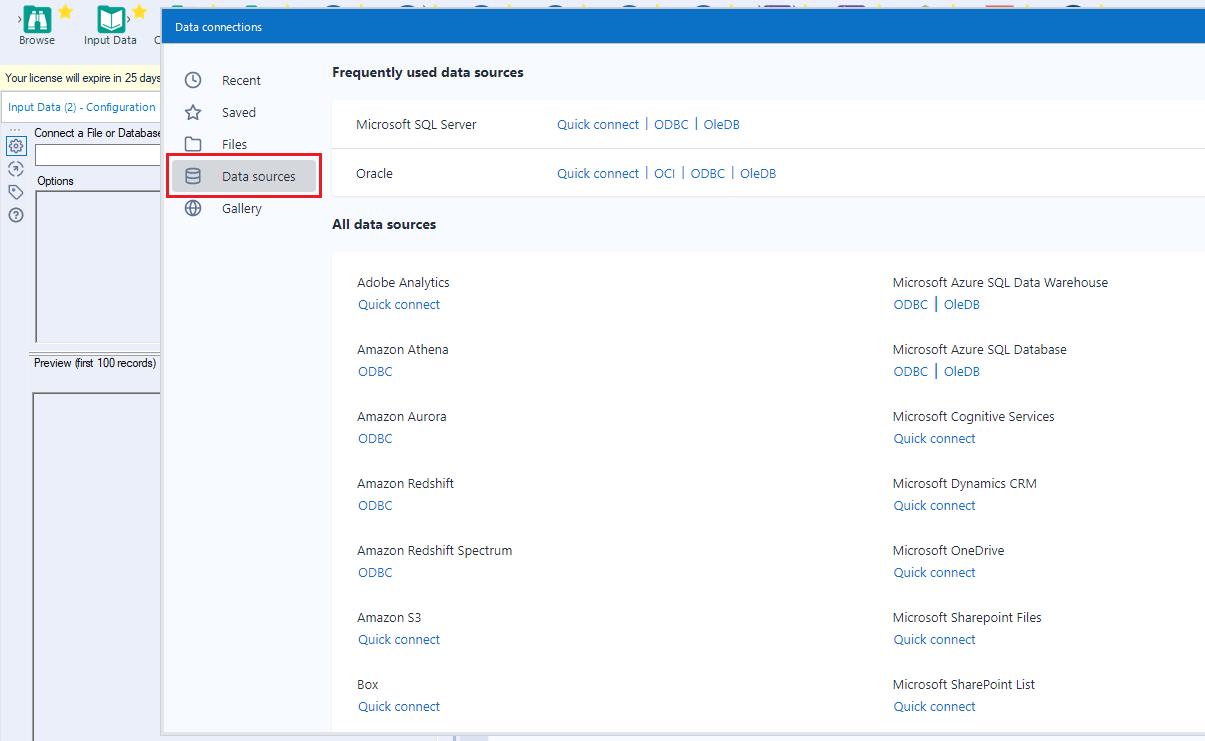

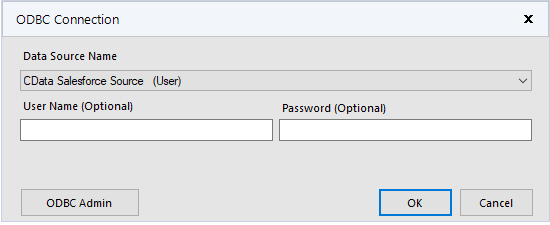

CData ODBC ドライバでは、1.データソースとしてSpark の接続を設定、2.Alteryx Designer 側でODBC Driver との接続を設定、という2つのステップだけでデータソースに接続できます。以下に具体的な設定手順を説明します。

まずは、本記事右側のサイドバーからSparkSQL ODBC Driver の無償トライアルをダウンロード・インストールしてください。30日間無償で、製品版の全機能が使用できます。

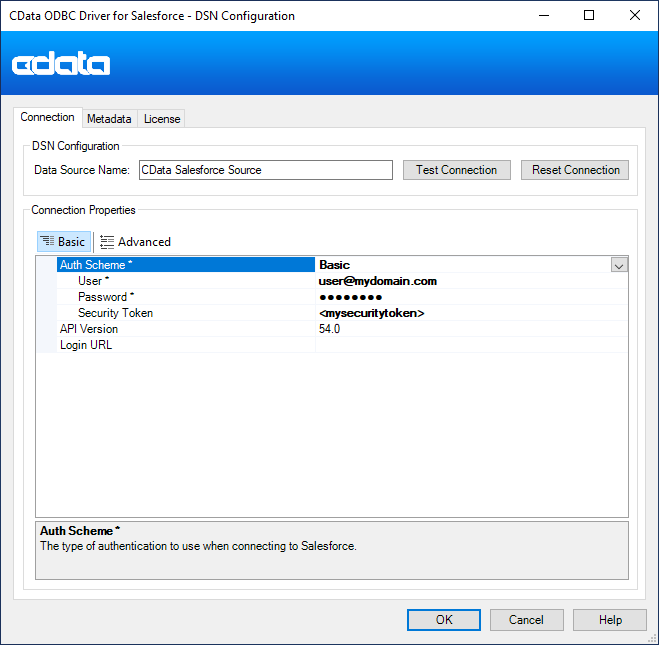

SparkSQL への接続を確立するには以下を指定します。

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

DSN を構成する際、Max Rows 接続プロパティも設定することができます。これを設定すると返される行数が制限されるため、レポートやビジュアライゼーションを作成する際のパフォーマンスが向上します。

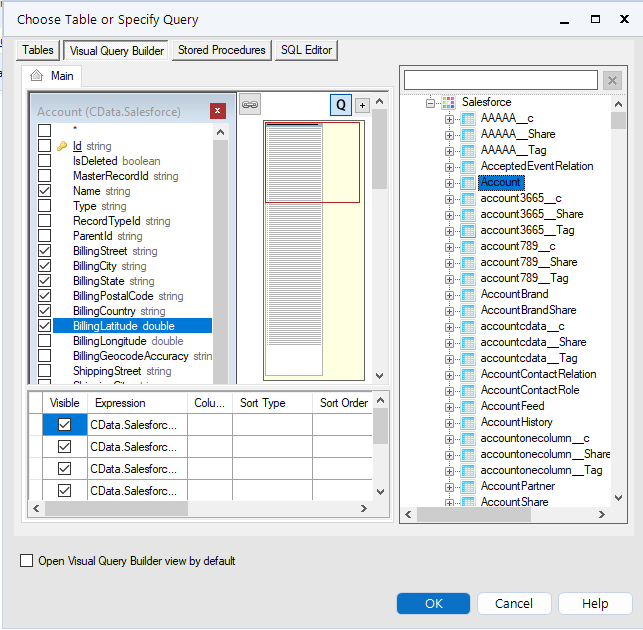

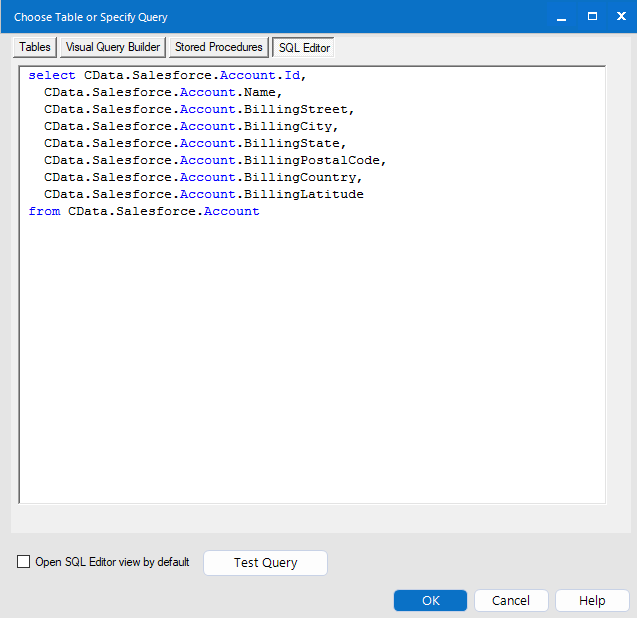

データセットをさらにカスタマイズする場合は、SQL エディタを開いてクエリを手動で変更し、句や集計などの操作を追加して、必要なSpark データを正確に取得できるようにします。

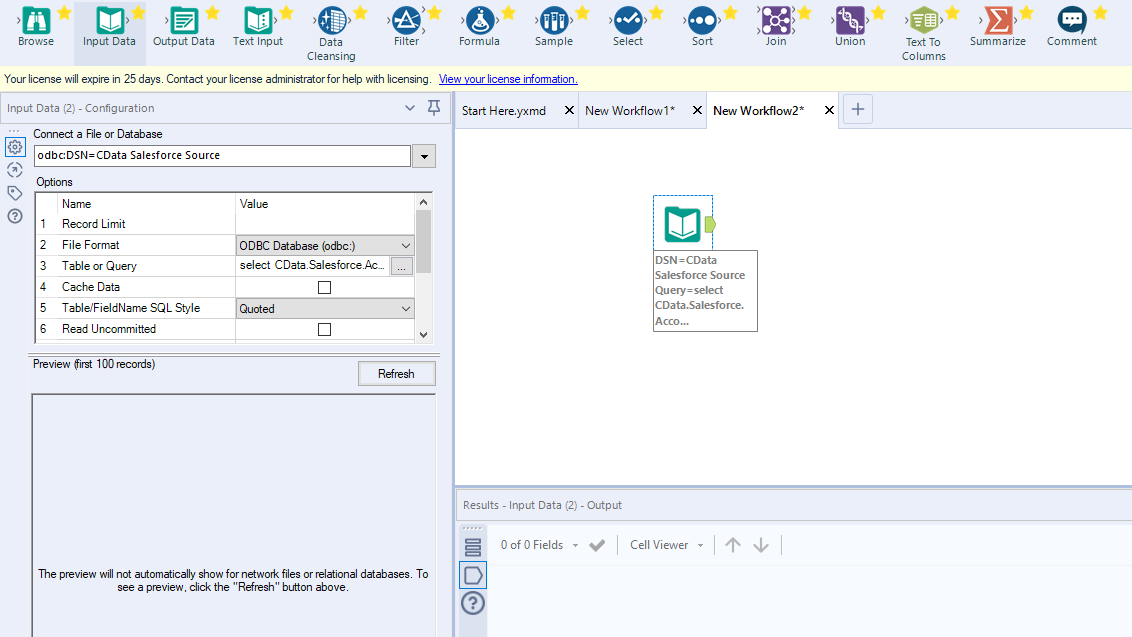

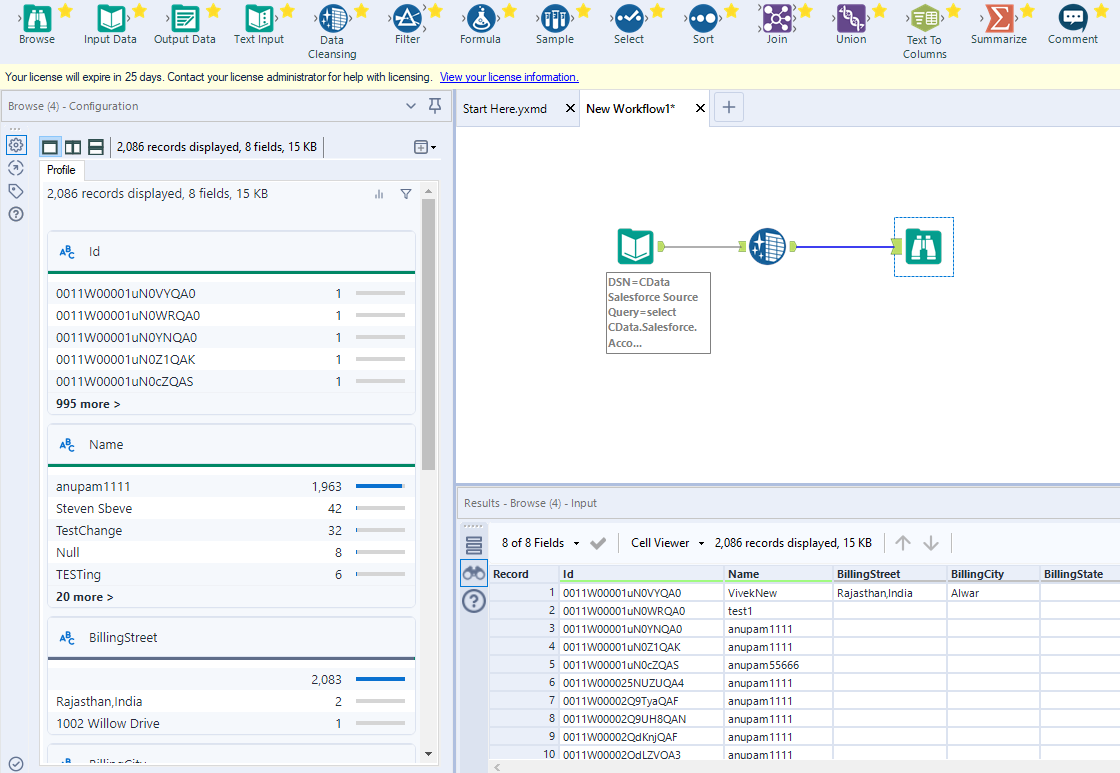

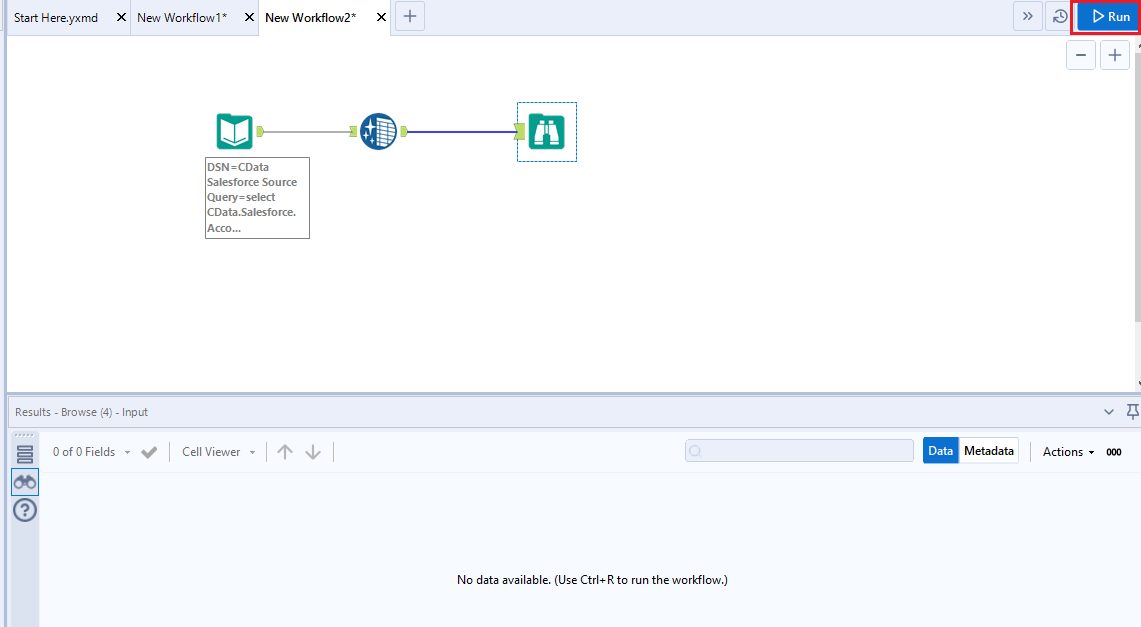

クエリを定義したら、Alteryx Designer でSpark データを操作できるようになります。

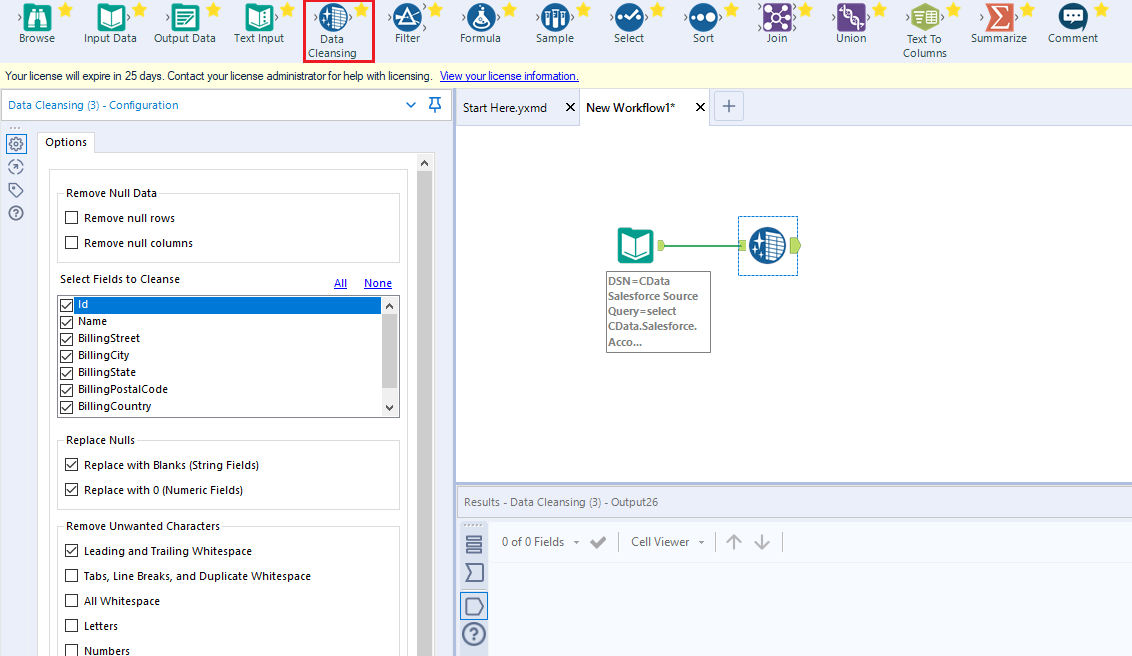

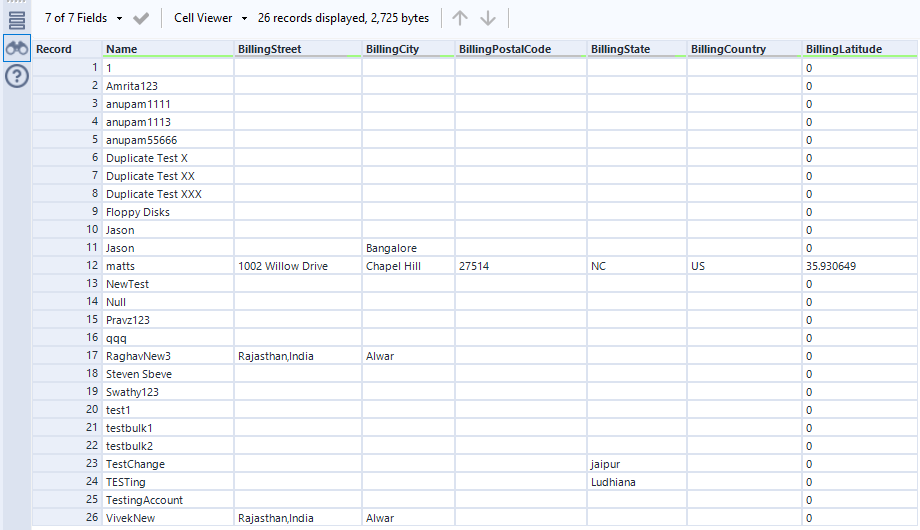

これで、Spark データを準備、ブレンディング、分析するためのワークフローを作成する準備ができました。CData ODBC ドライバは動的なメタデータ検出を実行し、Alteryx データフィールドタイプを使用してデータを表示し、Designer ツールを活用して必要に応じてデータを操作し、意味のあるデータセットを構築できるようにします。以下の例では、データをクレンジングして参照します。

高いパフォーマンスを発揮する組み込みのデータ処理により、Alteryx でSpark データを迅速にクレンジング、変換、分析することができます。