ノーコードでクラウド上のデータとの連携を実現。

詳細はこちら →こんにちは!リードエンジニアの杉本です。

コラボフロー(www.collabo-style.co.jp/ )は誰でも簡単に作れるクラウドベースのワークフローサービスです。コラボフローでは、申請フォームにJavaScriptを組み込むことで、外部のREST APIをコールして入力補完や連携を行うことができる機能を提供しています。この記事では、Azure Data Lake Storage データをCData API Server 経由でコラボフローの申請書入力画面から参照できるようにします。このLookup 参照により、申請フォームの入力を便利にすることができます。

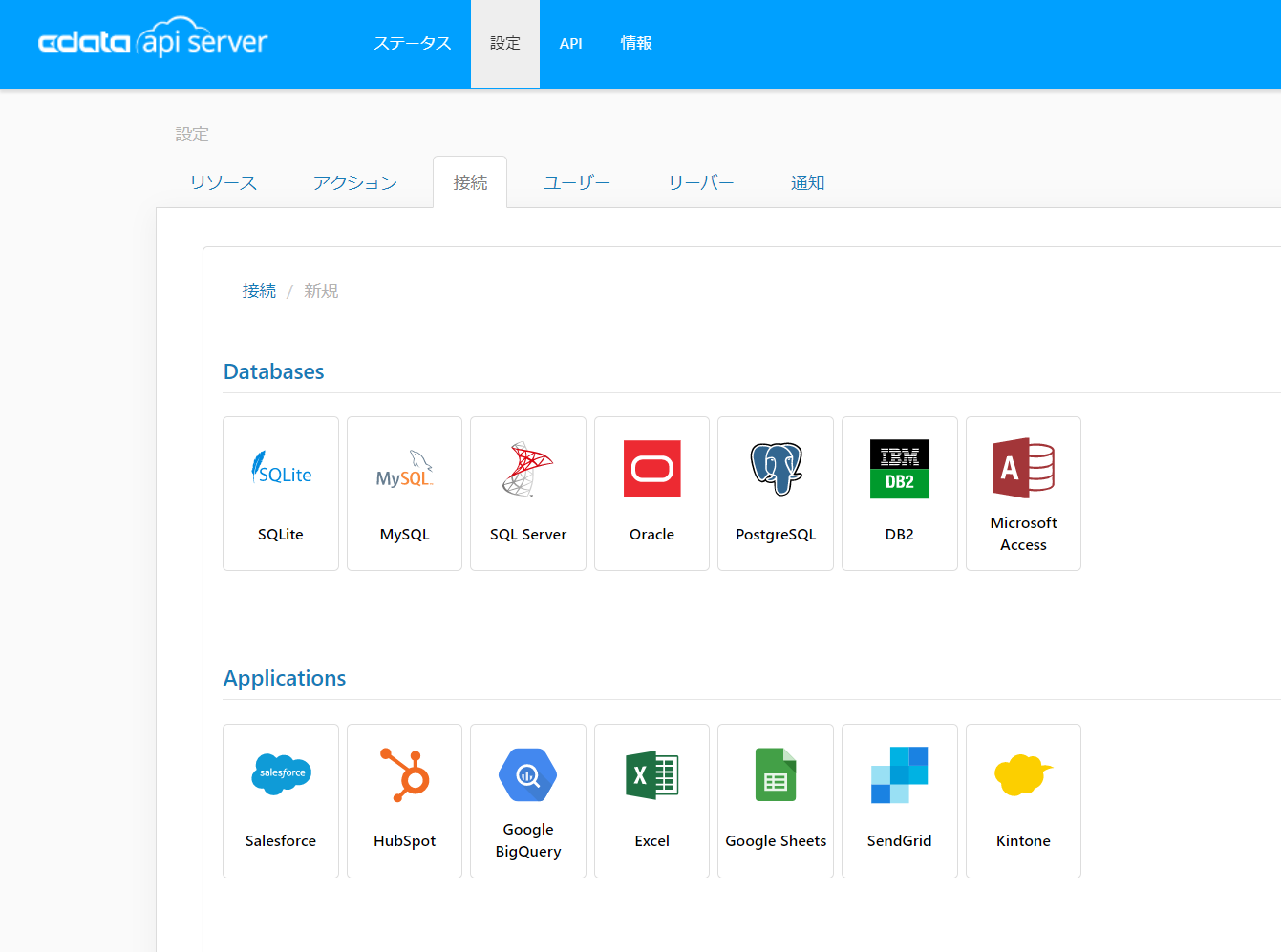

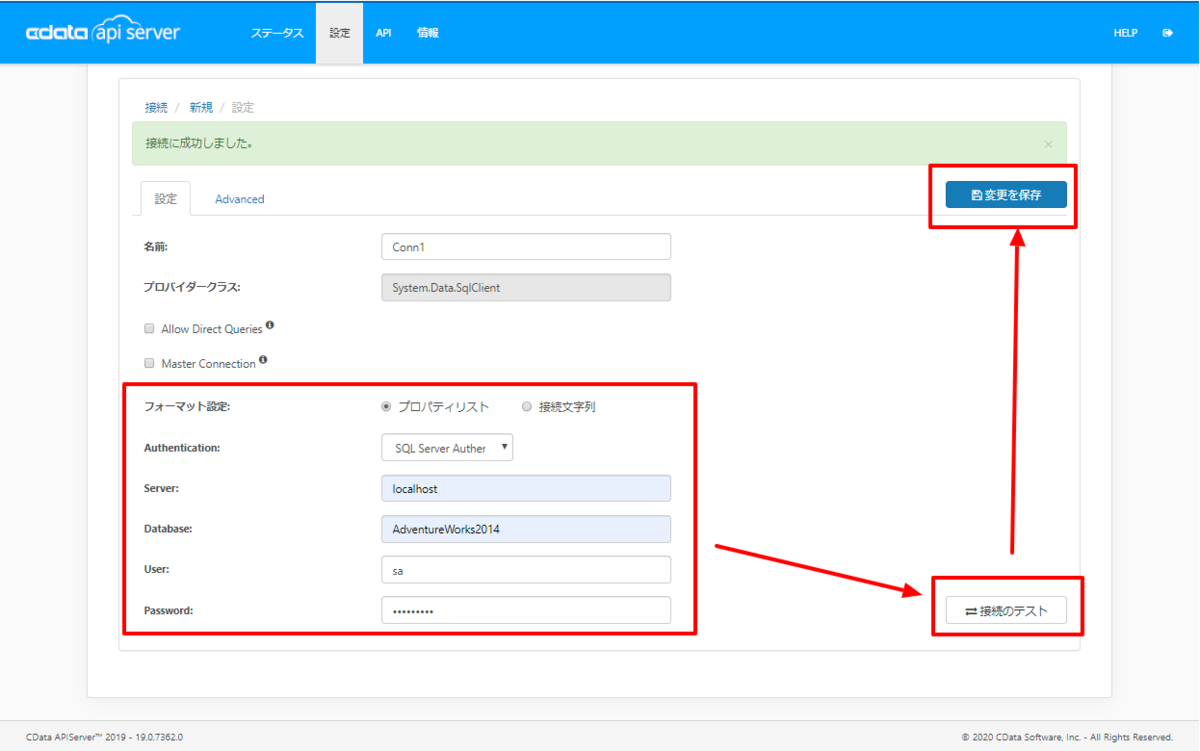

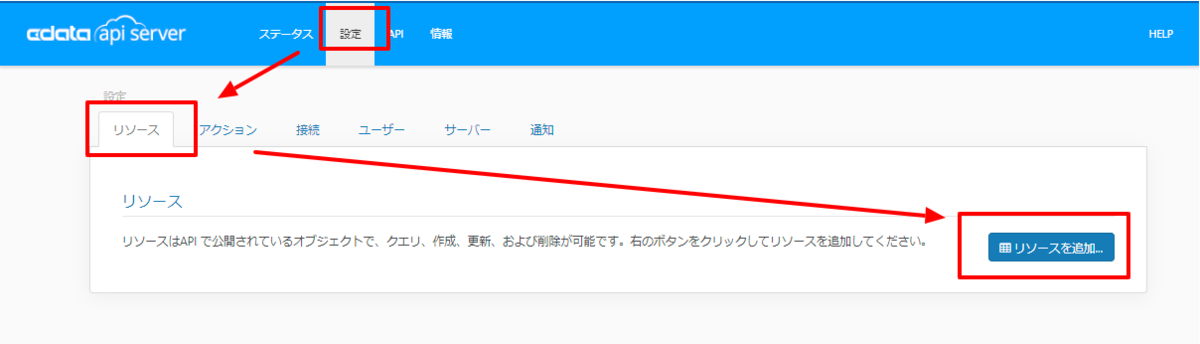

次のステップに従い、セキュアな REST API サービスを立ち上げます。

API Server はサーバー上で稼働します。Windows 版は、製品に組み込まれているスタンドアロンのサーバーかIIS に配置して稼働させることができます。Java 版では、Java servlet コンテナにAPI Server のWAR ファイルを配置します。 デプロイの詳細は製品ヘルプを参照してください。API Server を Microsoft Azure、 Amazon EC2、Heroku にデプロイする方法はKB に記事があります。

Gen 1 DataLakeStorage アカウントに接続するには、はじめに以下のプロパティを設定します。

Gen 1 は、認証方法としてAzure Active Directory OAuth(AzureAD)およびマネージドサービスID(AzureMSI)をサポートしています。認証方法は、ヘルプドキュメントの「Azure DataLakeStorage Gen 1 への認証」セクションを参照してください。

Gen 2 DataLakeStorage アカウントに接続するには、はじめに以下のプロパティを設定します。

Gen 2は、認証方法としてアクセスキー、共有アクセス署名(SAS)、Azure Active Directory OAuth(AzureAD)、マネージドサービスID(AzureMSI)など多様な方法をサポートしています。AzureAD、AzureMSI での認証方法は、ヘルプドキュメントの「Azure DataLakeStorage Gen 2 への認証」セクションを参照してください。

アクセスキーを使用して接続するには、AccessKey プロパティを取得したアクセスキーの値に、AuthScheme を「AccessKey」に設定します。

Azure ポータルからADLS Gen2 ストレージアカウントのアクセスキーを取得できます。

共有アクセス署名を使用して接続するには、SharedAccessSignature プロパティを接続先リソースの有効な署名に設定して、AuthScheme を「SAS」に設定します。 共有アクセス署名は、Azure Storage Explorer などのツールで生成できます。

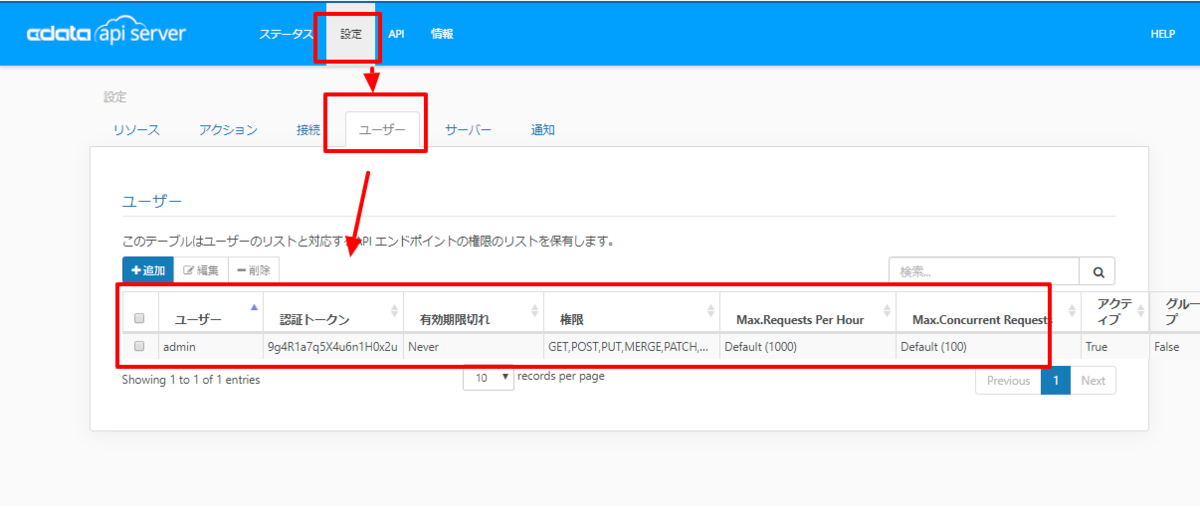

[設定]→[ユーザー]からAPI にアクセスできるユーザーの認証設定を行います。API Server はトークンでの認証を行うことができます。 IP アドレスでAPI へのアクセスを制限することも可能です。デフォルトではローカルマシンからのアクセスのみが許可されています。SSL の設定も可能です。

コラボフロー上で使用するAPI Server との接続用JavaScriptを準備します。

(function () {

'use strict';

// Setting Propeties

const AutocompleteSetting =

{

// Autocomplete target field for Collaboflow

InputName: 'fid0',

// Collaboflow item detils line number

ListRowNumber : 15,

// Autocomplete tartget field for API Server

ApiListupFiledColumn : 'adls_column',

// Key Column Name for API Server resource

ApiListupKeyColumn : 'adls_keycolumn',

// Mapping between Collaboflow field and API Server column

Mappings: [

{

PartsName: 'fid1', // Collabo flow field name

APIName: 'adls_column1' // API Server column name

},

{

PartsName: 'fid2',

APIName: 'adls_column2'

},

{

PartsName: 'fid3',

APIName: 'adls_column3'

},

{

PartsName: 'fid4',

APIName: 'adls_column4'

}

]

};

const CDataAPIServerSetting = {

// API Server URL

ApiServerUrl : 'http://XXXXXX',

// API Server Resource Name

ApiServerResourceName : 'adls_table',

// API Server Key

Headers : { Authorization: 'Basic YOUR_BASIC_AUTHENTICATION' },

// General Properties

ParseType : 'json',

get BaseUrl() {

return CDataAPIServerSetting.ApiServerUrl + '/api.rsc/' + CDataAPIServerSetting.ApiServerResourceName

}

}

let results = [];

let records = [];

// Set autocomplete processing for target input field

collaboflow.events.on('request.input.show', function (data) {

for (let index = 1; index < AutocompleteSetting.ListRowNumber; index++) {

$('#' + AutocompleteSetting.InputName + '_' + index).autocomplete({

source: AutocompleteDelegete,

autoFocus: true,

delay: 500,

minLength: 2

});

}

});

// This function get details from API Server, Then set values at each input fields based on mappings object.

collaboflow.events.on('request.input.' + AutocompleteSetting.InputName + '.change', function (eventData) {

debugger;

let tartgetParts = eventData.parts.tbl_1.value[eventData.row_index - 1];

let keyId = tartgetParts[AutocompleteSetting.InputName].value.split(':')[1\;

let record = records.find(x => x[AutocompleteSetting.ApiListupKeyColumn] == keyId);

if (!record)

return;

AutocompleteSetting.Mappings.forEach(x => tartgetParts[x.PartsName].value = '');

AutocompleteSetting.Mappings.forEach(x => tartgetParts[x.PartsName].value = record[x.APIName]);

});

function AutocompleteDelegete(req, res) {

let topParam = '&$top=10'

let queryParam = '$filter=contains(' + AutocompleteSetting.ApiListupFiledColumn + ',\'' + encodeURIComponent(req.term) + '\')';

collaboflow.proxy.get(

CDataAPIServerSetting.BaseUrl + '?' +

queryParam +

topParam,

CDataAPIServerSetting.Headers,

CDataAPIServerSetting.ParseType).then(function (response) {

results = [];

records = [];

if (response.body.value.length == 0) {

results.push('No Results')

res(results);

return;

}

records = response.body.value;

records.forEach(x => results.push(x[AutocompleteSetting.ApiListupFiledColumn] + ':' + x[AutocompleteSetting.ApiListupKeyColumn]));

res(results);

}).catch(function (error) {

alert(error);

});

}

})();

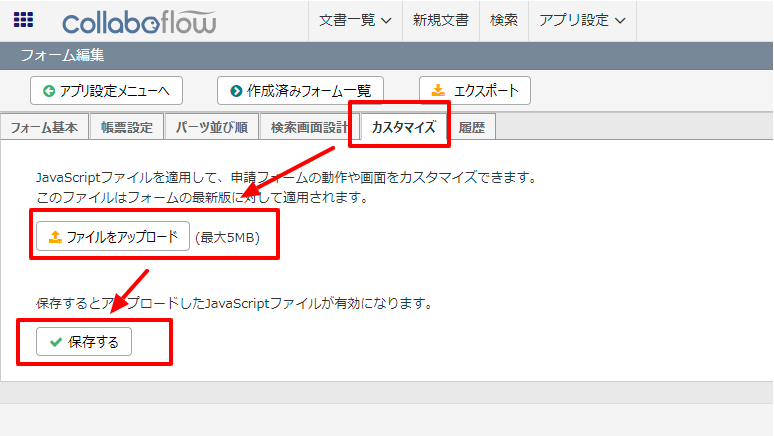

JavaScriptを作成したら、後はコラボフローにアップするだけです。

このように Azure Data Lake Storage 内のデータをコラボフローで利用することができるようになります。CData API Server は、30日の無償評価版があります。是非、お試しいただき、コラボフローからのデータ参照を体感ください。