ノーコードでクラウド上のデータとの連携を実現。

詳細はこちら →

CData

こんにちは!プロダクトスペシャリストの宮本です。

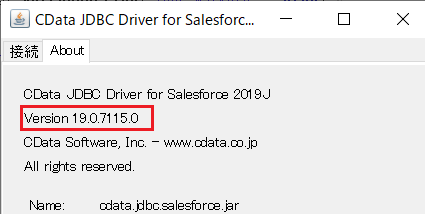

Google Cloud Data Fusion は、ノーコードでデータ連携の設定が可能な言わば GCP の ETL ツール(サービス)です。たくさんのコネクタや変換・分析機能がデフォルトで用意されているため、さまざまなデータソースを色々な組み合わせで扱うことが可能なようです。 また JDBC を扱うこともできるため、この記事では、CData JDBC Driver for HCL Domino データ を使って、HCL Domino データ データをCloud Data Fusion でGoogle BigQuery にノーコードでパイプラインします。

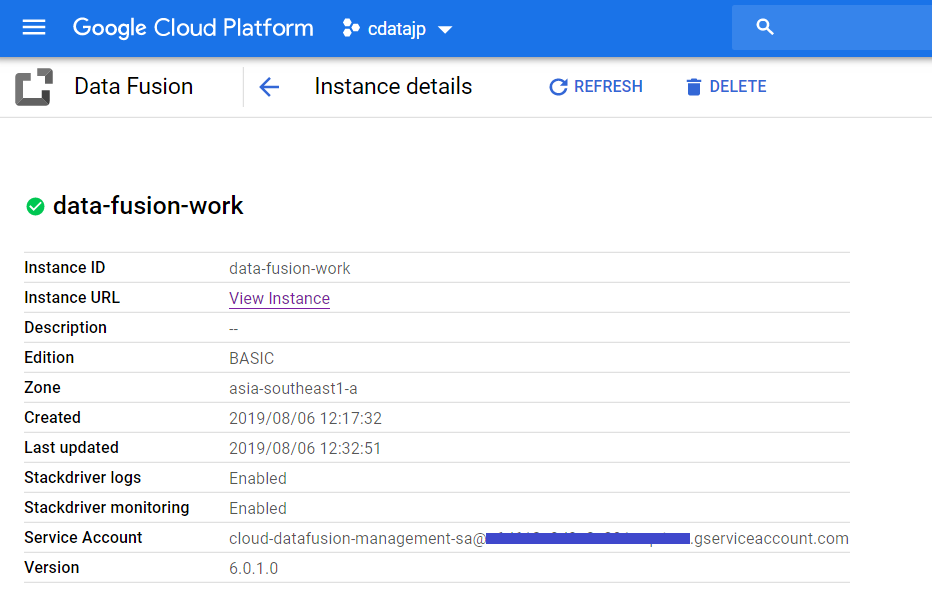

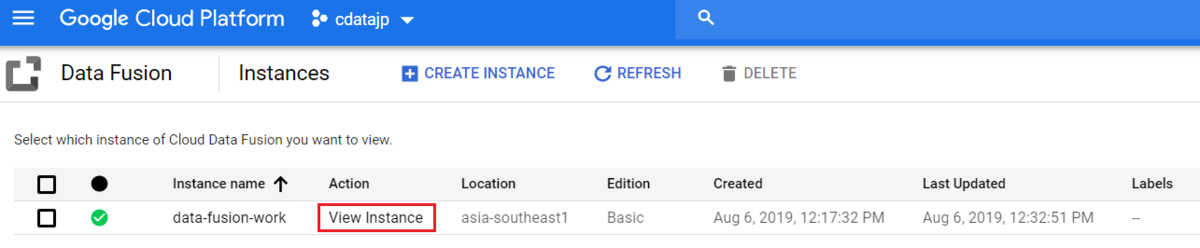

まずはCloud Data Fusion のインスタンスを作成します。

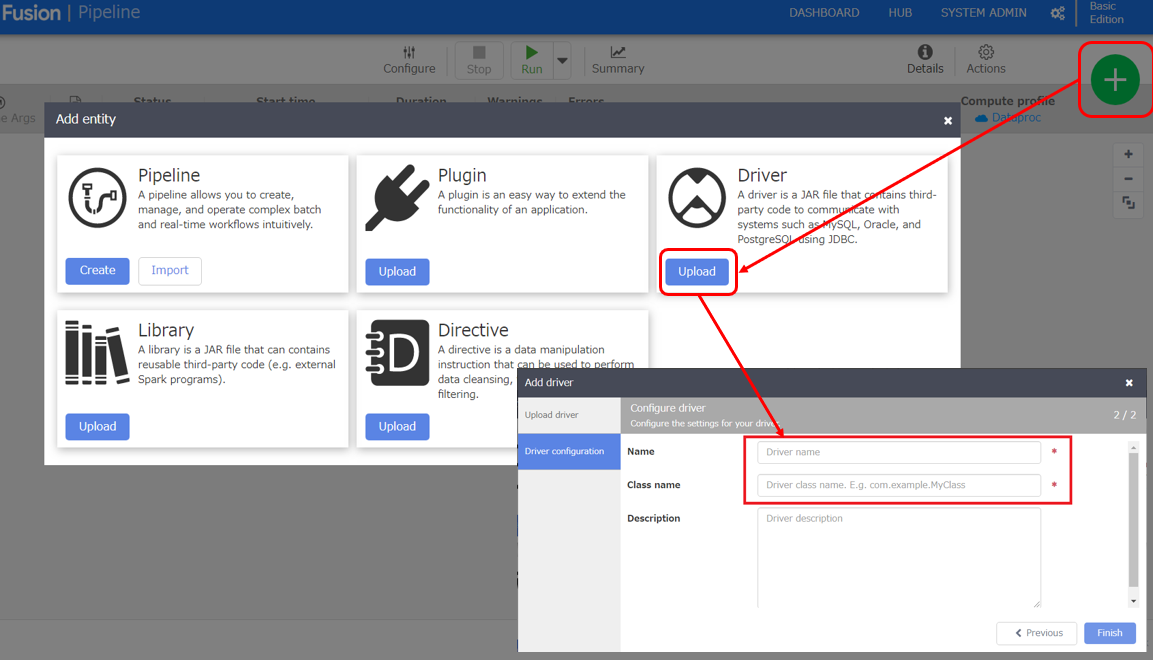

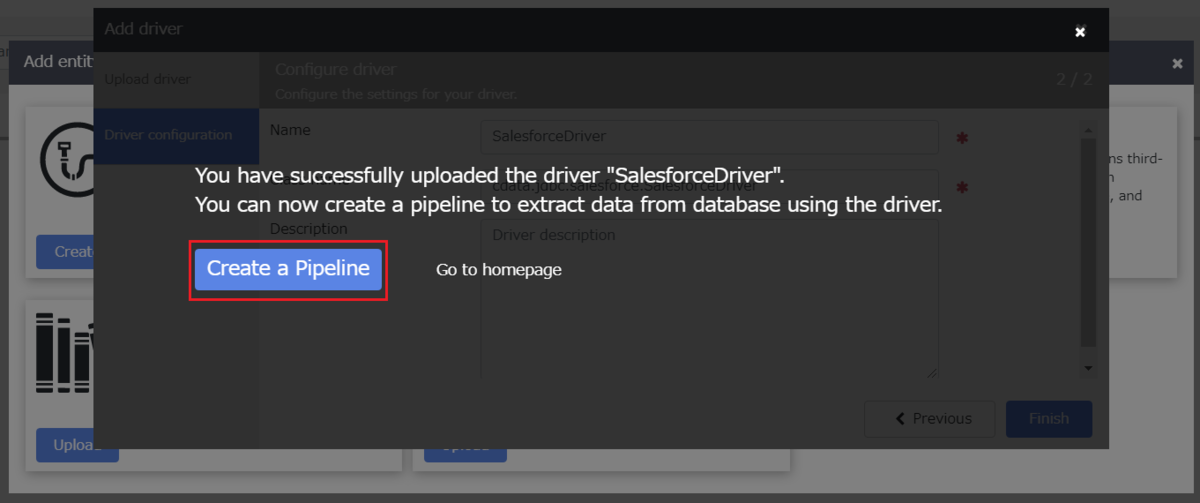

ここからは実際に、Data Fusion の設定をしていきます。 まずは JDBC Driver をアップロードを行います。

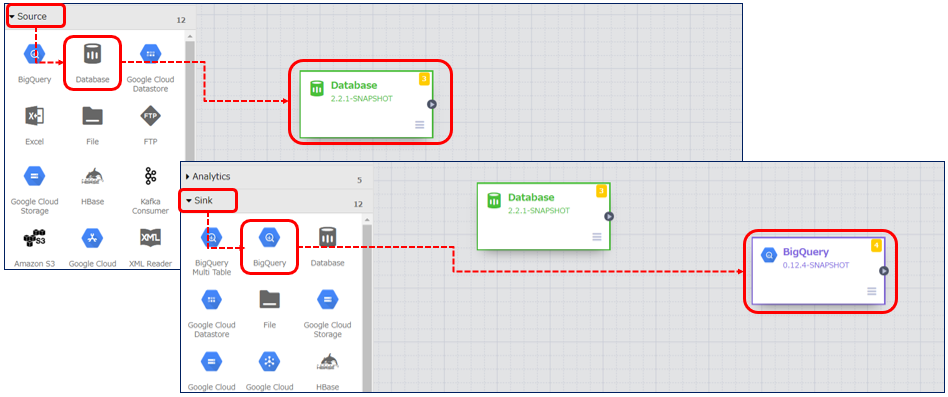

インプット元はサイドメニューの「Source」から選択します。今回は先ほどアップロードした HCL Domino データ の JDBC Driver を使用するため、「DataBase」を選択します。 アウトプット先は同じくサイドメニューより「Sink」→「BigQuery」を選択します。

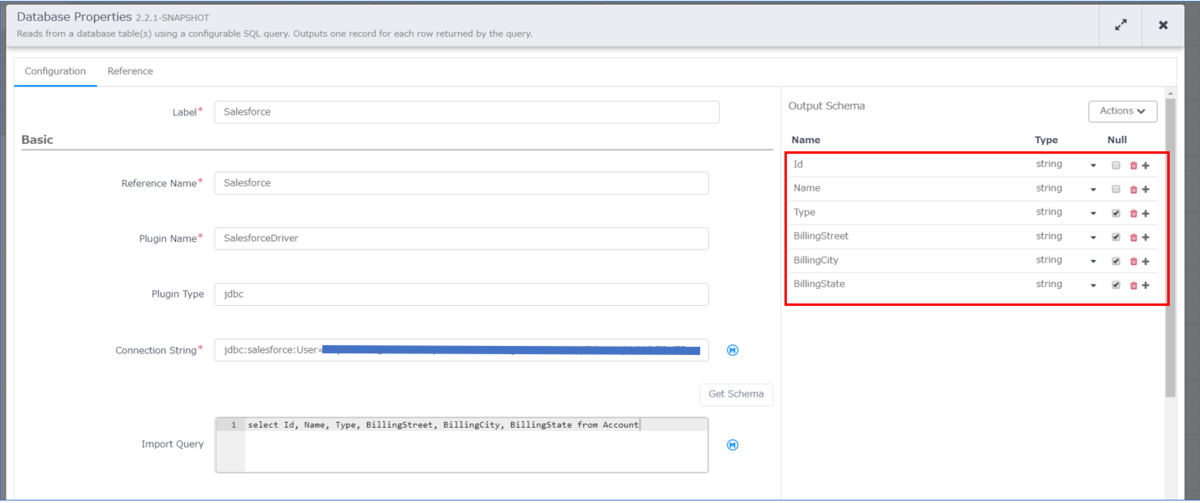

「DataBase」のアイコンにカーソルを持ってくるとプロパティというボタンが表示されるのでクリックし、下記内容を設定します。

CData 製品を経由してDomino に接続するには、「Proton コンポーネント」のインストールが必要です。通常、 Proton はAppDev パックの一部として配布されています。Proton またはAppDev パックの入手およびインストール方法については、HCL のドキュメントを参照してください。

CData 製品は匿名アクセス、またはクライアント証明書の提供によりProton を認証できます。 これらのオプションは両方ともDomino で特定の設定が必要です。

次の2セクションでは、接続に必要な事前設定について説明します。使用したい認証方法に対応するセクションを参照してください。

クライアント証明書による認証では、CData 製品は専用のユーザーアカウントとして接続します。このユーザーには、接続するすべてのデータベースに対するdesigner またはそれ以上のアクセス権が付与する必要があります。

また、CData 製品を使用するためにはユーザーがインターネット証明書を取得する必要があります。サーバーコンソールで以下のコマンドを実行することで、Proton にこの証明書を作成させることができます。 APPUSER はCData 製品でアクセス設定するユーザーアカウント名、ADMINISTRATOR は証明書を受け取るユーザー名です。

load proton --setupclient "APPUSER" --sendto "ADMINISTRATOR"新しい証明書は、Notes のADMINISTRATOR メールボックスから利用できます。証明書は、クライアント証明書(clientcert)およびキー(clientkey)の2ファイルに分けて送信される場合があります。 キーファイルのテキストを証明書ファイルの末尾にコピーアンドペーストして、2つのファイルを結合する必要があります。

匿名アクセスでは、CData 製品はAnonymous という一般的なユーザーアカウントで接続します。 接続するすべてのデータベースには、次の2つの権限が設定される必要があります。

接続するには以下を設定します。

CData 製品は、クライアント証明書を使用してProton に認証することも、匿名アクセスで認証することも可能です。

クライアント証明書で認証するには以下を設定します。

匿名認証を使用するには、AuthScheme をAnonymous に設定します。

Connection String は以下の形式です。

jdbc:domino:Server=https://domino.corp.com;Database=names.nsf;Port=3002;SSLClientCertType=PEMKEY_FILE;SSLClientCert=full_path_of_certificate.pem;SSLServerCert=*

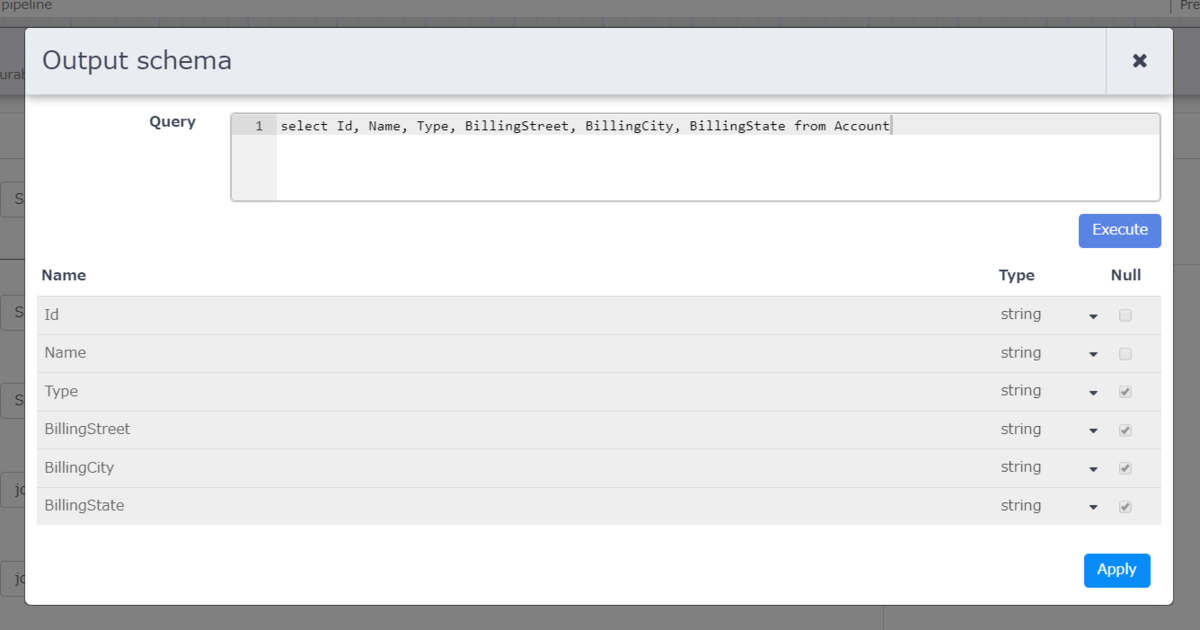

上のキャプチャの赤枠は、Salesforce から BigQuery へアウトプットするデータの定義となります。 こちらは「Import Query」のすぐ右上にある「Get Schema」をクリックすると下の画面が表示されますので、「Import Query」で入力したクエリを実行し、カラムを定義します。

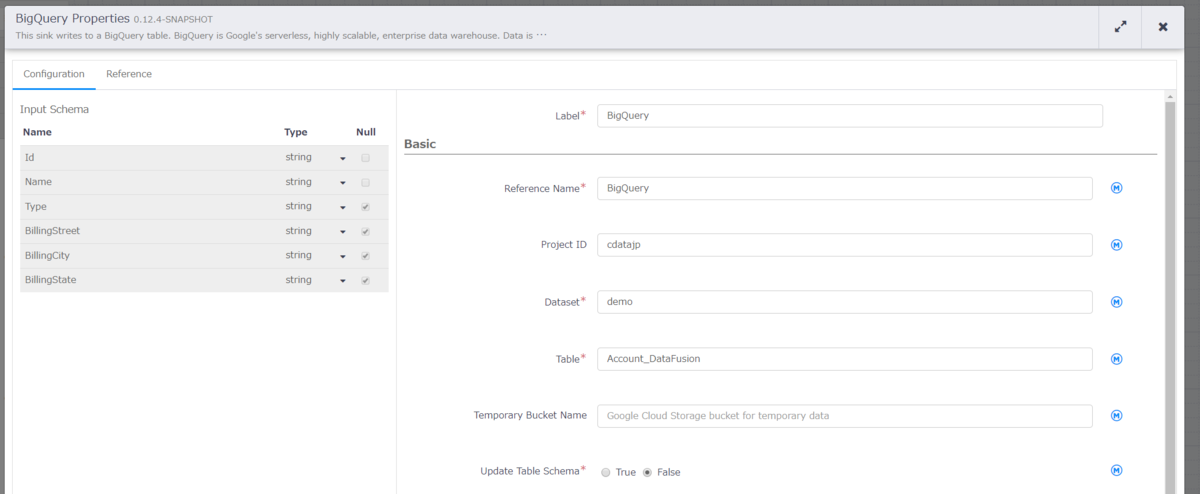

こちらも同様に BigQuery のプロパティから下記内容を設定します。

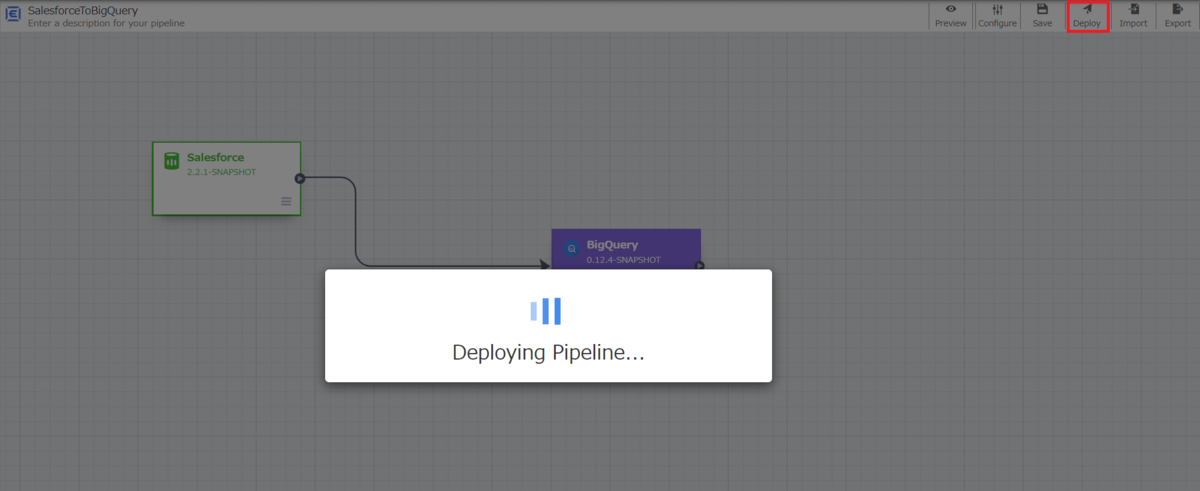

まずは作成したパイプラインをデプロイします。赤枠の「Deploy」ボタンをクリックしてデプロイを行います。

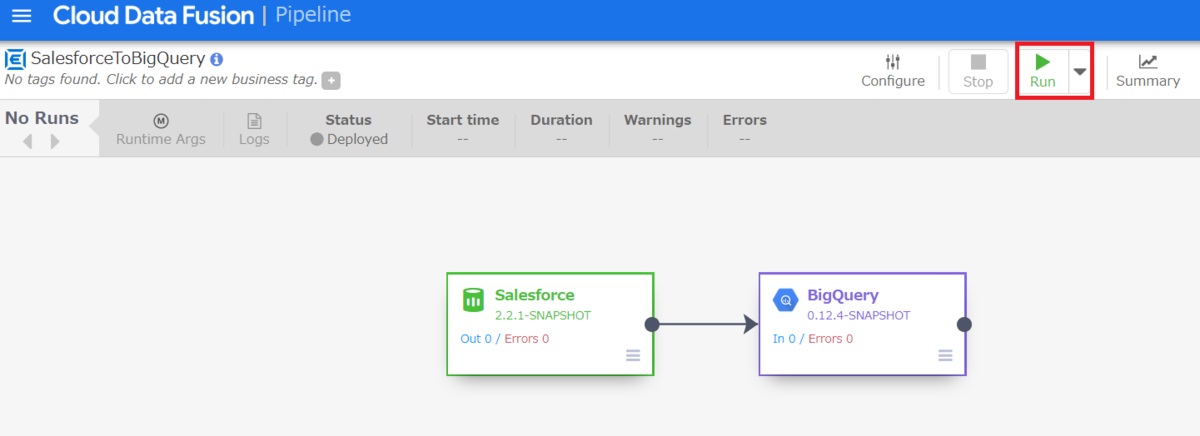

デプロイ完了後、Runボタンが表示されますので、クリックします。

このようにCData JDBC ドライバをアップロードすることで、簡単にGoogle Cloud Data Fusion でHCL Domino データ データをノーコードで連携し、BigQuery などへのパイプラインを作成することができます。

是非、CData JDBC Driver for Domino 30日の無償評価版 をダウンロードして、お試しください。