ノーコードでクラウド上のデータとの連携を実現。

詳細はこちら →

CData

こんにちは!ウェブ担当の加藤です。マーケ関連のデータ分析や整備もやっています。

Elasticsearch は、人気の分散型全文検索エンジンです。データを一元的に格納することで、超高速検索や、関連性の細かな調整、パワフルな分析が大規模に、手軽に実行可能になります。Elasticsearch にはデータのローディングを行うパイプラインツール「Logstash」があります。CData Drivers を利用することができるので、30日の無償評価版をダウンロードしてあらゆるデータソースを簡単にElasticsearch に取り込んで検索・分析を行うことができます。

この記事では、CData Driver for SSAS を使って、SQL Analysis Services のデータをLogstash 経由でElasticsearch にロードする手順を説明します。

それでは、Logstash でElasticsearch にSQL Analysis Services データの転送を行うための設定ファイルを作成していきます。

接続するには、Url プロパティを有効なSQL Server Analysis Services エンドポイントに設定して認証を提供します。XMLA アクセスを使用して、HTTP 経由でホストされているSQL Server Analysis Services インスタンスに接続できます。 Microsoft ドキュメント configure HTTP access を参照してSQL Server Analysis Services に接続してください。

SQL をSQL Server Analysis Services に実行するには、ヘルプドキュメントの「Analysis Services データの取得」を参照してください。接続ごとにメタデータを取得する代わりに、CacheLocation を設定できます。

AuthScheme を"Basic" または"Digest" に設定してUser とPassword を設定します。CustomHeaders に他の認証値を指定します。

Windows のUser とPassword を設定して、AuthScheme をNTLM に設定します。

Kerberos を認証するには、AuthScheme をNEGOTIATE に設定します。Kerberos 委任を使うには、AuthScheme をKERBEROSDELEGATION に設定します。必要があれば、User、Password およびKerberosSPN を設定します。デフォルトでは、CData 製品は指定されたUrl でSPN と通信しようと試みます。

デフォルトでは、CData 製品はサーバーの証明書をシステムの信頼できる証明書ストアと照合してSSL/TLS のネゴシエーションを試みます。別の証明書を指定するには、利用可能なフォーマットについてヘルプドキュメントの「SSLServerCert」プロパティを参照してください。

接続を設定したら、その後はあらゆるキューブを二次元テーブルとして扱うことができます。データに接続する際にCData 製品がSSAS のメタデータを取得して、動的にテーブルスキーマを更新します。 「CacheLocation」プロパティを設定すれば自動でファイルにキャッシュを作成するので、接続時に毎回メタデータを取得する必要もなくなります。

詳細は、ヘルプドキュメントの「Retrieving Analysis Services Data」を参照してください。

input {

jdbc {

jdbc_driver_library => "../logstash-core/lib/jars/cdata.jdbc.ssas.jar"

jdbc_driver_class => "Java::cdata.jdbc.ssas.SSASDriver"

jdbc_connection_string => "jdbc:ssas:User=myuseraccount;Password=mypassword;URL=http://localhost/OLAP/msmdpump.dll;"

jdbc_user => ""

jdbc_password => ""

schedule => "*/30 * * * * *"

statement => "SELECT Fiscal_Year, Sales_Amount FROM Adventure_Works"

}

}

output {

Elasticsearch {

index => "ssas_Adventure_Works"

document_id => "xxxx"

}

}

それでは作成した「logstash.conf」ファイルを元にLogstash を実行してみます。

> logstash-7.8.0\bin\logstash -f logstash.conf

成功した旨のログが出ます。これでSQL Analysis Services データがElasticsearch にロードされました。

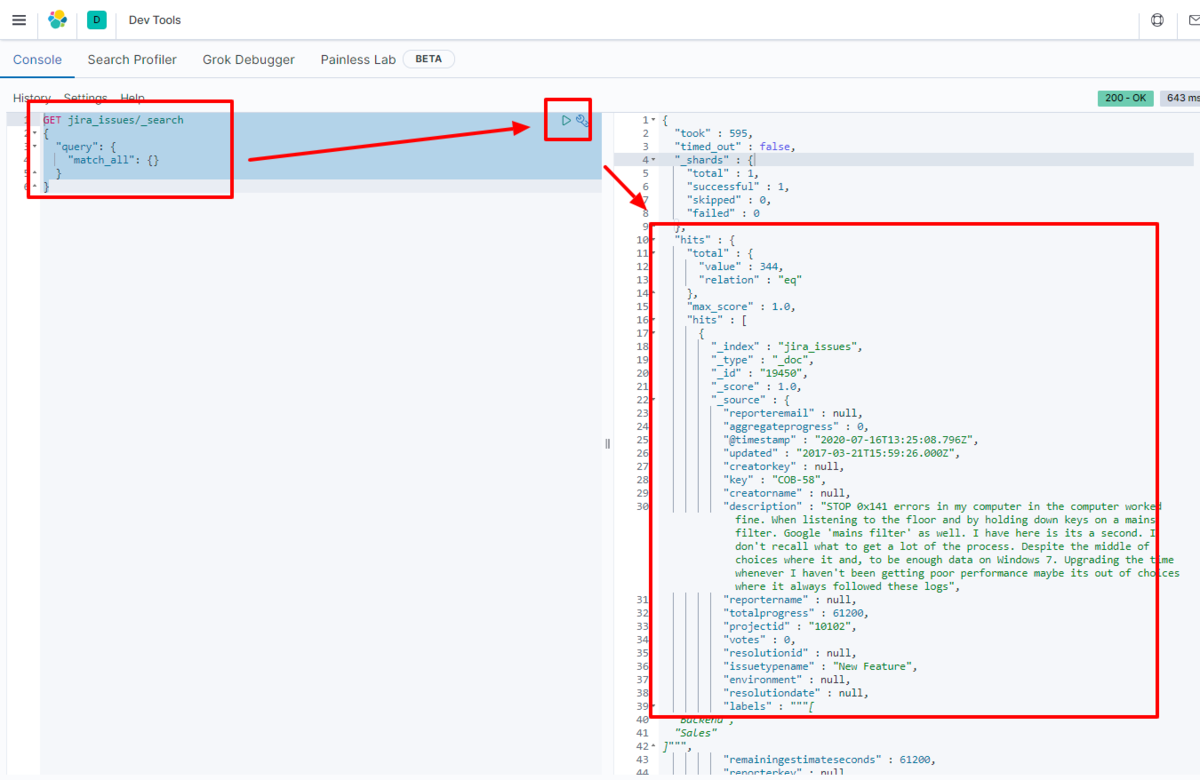

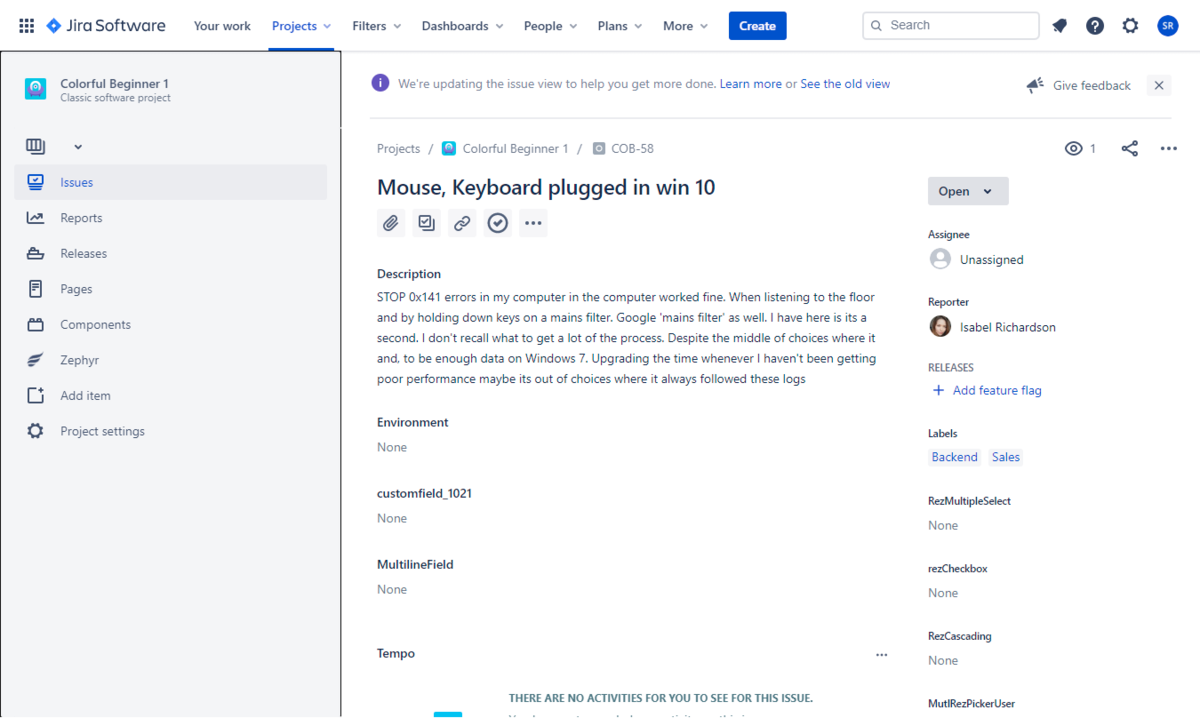

例えばKibana で実際にElasticsearch に転送されたデータを見てみます。

GET ssas_Adventure_Works/_search

{

"query": {

"match_all": {}

}

}

データがElasticsearch に格納されていることが確認できました。

CData JDBC Driver for SSAS をLogstash で使うことで、SQL Analysis Services コネクタとして機能し、簡単にデータをElasticsearch にロードすることができました。ぜひ、30日の無償評価版をお試しください。